Neuronale Netze, Teil 2: Das Netz der Neuronen – inspiriert durch die Biologie

16. Dezember 2020

Neuronale Netze sind Verbindungsstrukturen aus künstlichen Neuronen, deren Aufbau und Funktionsweise ich in Neuronale Netze, Teil 1: Das Neuron – inspiriert durch die Biologie beschrieben habe. Neuronale Netze sind inspiriert durch die Natur, modellieren funktional deren Weise, intelligente Aufgaben wie z.B. Prognosen durchzuführen.

Die Topologie, also der Aufbau eines Netzes ist immer von der jeweils zu erfüllenden Aufgabe abhängig. Moderne Ausprägungen unterscheiden dabei immer drei Layer-Ebenen:

- den Input-Layer: er bildet den Eingang des Netzes und nimmt Signale der Außenwelt auf, an ihm liegen gewissermaßen die Parameter des Modells, die Features an. Für die Prognose des Hauspreises wären dies zum Beispiel Eingänge wie Größe in qm, Anzahl der Zimmer, Lage, Keller usw.

- die Hidden-Layer: Hier erfolgen interne Bearbeitungsschritte. Wie viele Hidden Layer existieren, hängt von der jeweiligen Aufgabe ab.

- der Output-Layer: Hier liegen die durch das neuronale Netz erzeugten Ausgabewerte an: Beim Beispiel Hauspreis könnte hier genau ein Ausgang den vorhergesagten Preis ausgeben.

Neuronale Netze werden immer supervised anhand von Trainingsdaten trainiert ( „supervised learning“, siehe Künstliche Intelligenz – ein Einstieg) und können dann in der Nutzungsphase ihre Aufgabe erfüllen. Durch ihre Struktur ergeben sich folgende Besonderheiten:

- Das gelernte Wissen ist in neuronalen Netzen verteilt, das Wissen findet sich nicht nur an einer Stelle.

- Sieht man jedes Neuron als eine Verarbeitungseinheit, so können Verarbeitungsschritte parallel durchgeführt werden.

- Es ist schwer bis unmöglich, bei hochkomplexen neuronalen Netzen ihre genaue Funktionsweise zu beschreiben. Dies ist das Forschungsfeld der Explainable AI. Anders als in einem von einem Programmierer geschriebenen Programm können damit „Fehler“ und Verhaltensweisen nicht mehr auf der Ebene eines für Menschen verständlichen Codes nachvollzogen werden. Weil die Verhaltensweise der Netze für komplexe Probleme so komplex ist, kann auch keine einfache Beschreibung geliefert werden. Dies wirft im Moment beim Einsatz neuronaler Netze rechtliche und ethische Fragen auf.

Das Lernen der Netze funktioniert wie folgt: Die gelernten Muster werden in den Gewichten der Neuronen und den für die Neuronen festgelegten Schwellwerten gespeichert. Man kann sich das vereinfacht so vorstellen: Ähnlich wie im menschlichen Gehirn werden die Verbindungen zwischen musterbestätigenden Neuronen dicker, das heißt die Gewichte werden höher. Umgekehrt werden andere Verbindungen schwächer, ihre Gewichte werden kleiner. Auch der Schwellwert wird über ein eigenes Eingangsneuron und entsprechende Gewichte mitgelernt. Zum Lernen werden die Trainingsdaten eines nach dem anderen am Netz angelegt, am Ausgang wird dann der Fehler zum erwarteten Ergebnis bestimmt. Dieser Fehler wird dann durch alle Schichten „zurückgerechnet“. Dieser Vorgang nennt sich Backpropagation. Schicht für Schicht werden die Gewichte und Schwellwerte der Neuronen so angepasst, dass der gemeldete Fehler möglichst klein wird. Hat man für ausreichend Trainingsdaten diese Anpassungen vorgenommen (die Fehler wurden durch Backpropagation jeweils korrigiert), so eignet sich das Netz mit einer gewissen Performance (Genauigkeit) dann für die Nutzung.

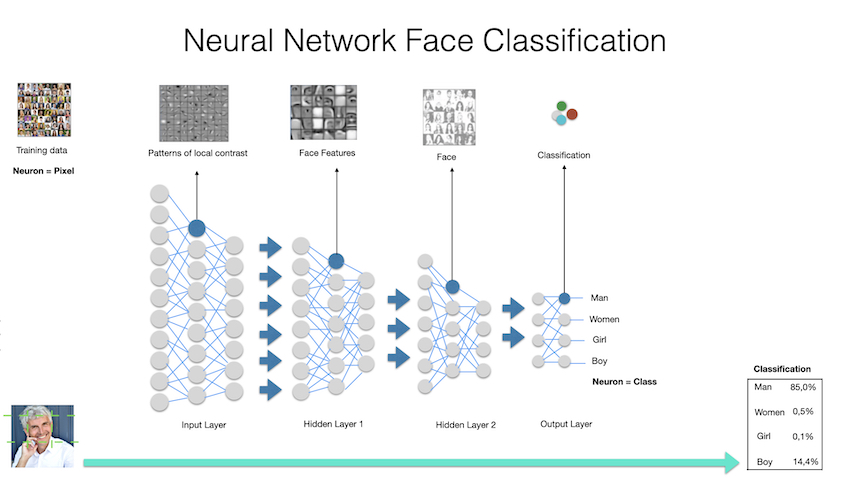

Schauen wir uns das Ganze mal am Beispiel der Gesichtserkennung durch ein Neuronales Netz an, verdeutlicht durch die folgende Abbildung:

Am Input Layer legt man zum Trainieren jede Menge Trainingsdaten an. Jedes Eingangsneuron verarbeitet ein Pixel. Das Netz wird für ein Klassifikationsproblem mit 4 Klassen (Man, Women, Girl, Boy) trainiert. 4 Ausgabeneuronen geben die Wahrscheinlichkeit für jeweils eine Klasse aus. Interessanterweise lernt das Netz in unterschiedlichen Tiefen unterschiedliche Strukturen:

- Im Input Layer werden verschiedene Kontrastmuster gelernt.

- Im Hidden Layer 1 werden Gesichtsmuster wie Nasenbögen, Augenformen oder Augen-Augenbrauen Muster gelernt.

- Im Hidden Layer 2 werden Muster ganzer Gesichter gelernt.

- Im Output Layer werden Muster der Klassifikation in unsere 4 Klassen gelernt.

Nach dem Trainingsvorgang ist es dann möglich, dass mein Gesicht durch das neuronale Netz richtig klassifiziert wird.

Tiefe neuronale Netze sind im Moment Gegenstand der Forschung und es werden für spezielle Anwendungsfelder fast jedes Jahr überragende Ergebnisse erzielt. So kann ich in Zukunft noch viele Artikel über spezielle Neuronale Netze schreiben, z.B. über:

- CNN (Convolutional Neural Networks), die für das Q-Learning beim Reinforcement Learning verwendet werden oder für die Verarbeitung von Bild- und Audiodaten.

- GAN (Generative Adversarial Networks) bestehen aus zwei Neuronalen Netzen. Eines davon erstellt Kandidaten, das andere bewertet die vom ersten Netz erstellten Kandidaten. GANs werden erfolgreich beim Generieren realistischer Inhalte (Text, Video, Foto, …) erfolgreich eingesetzt. So können z.B. ihre Fotos in Bilder im Van Gogh Style umgerechnet werden.

- RNN (Recurrent Neural Networks), die nicht nur Vorwärtsverbindungen im Netz haben (wie in unserem Beispiel), sondern wo sich Neuronen auch wieder mit vor ihnen liegenden Neuronen verbinden. Hierdurch ergeben sich Modellierungsmöglichkeizen für Zeitverzögerungen und Struktutren für ein Gedächtnis. RNNs werden bei der Verarbeitung von Sequenzen eingesetzt, etwa beim Verstehen von Text.

Ich hoffe, dieser vereinfachte und kurze Überblick hilft Ihnen zu verstehen, wie Neuronale Netze funktionieren und dass sie für sehr unterschiedliche Einsatzgebiete ein mächtiges Werkzeug bieten. Welche phantastischen Fortschritte in anderen Wissenschaften durch tiefe Neuronale Netze möglich sind, zeigt der folgende Artikel:

‘It will change everything’: DeepMind’s AI makes gigantic leap in solving protein structures

Wer mehr zum Thema Machine Learning wissen möchte, findet hier Anregung:

- Machine Learning: Schlüsselwerkzeug für disruptive digitale Transformation

- Künstliche Intelligenz – ein Einstieg

- Künstliche Intelligenz – Weckruf für das C-Level

Quelle Grafik: Setzwein IT-Management GmbH (Copyright)

Quelle Foto: @Jutta albers – Pexels.com

| Keine Kommentare